Razvoj tehnologije stvaranja umjetnih lica je nevjerojatan. Ovako bi izgledala Mona Lisa da govori

Deepfake brzo je razvijajuća tehnologija stvaranja umjetnih lica koja ima mnoge pozitivne i negativne strane

Suvišno je pričati o tome koliko se tehnologija bizarno brzo razvija i do kojih granica je umjetna inteligencija stigla. Jedna od inteligentnih tehnologija, a na koju sve više stručnjaka upozorava, je deepfake. Radi se o tehnologiji koja putem umjetne inteligencije može stvoriti nove slike lica, ali i videa, a u zadnje vrijeme se često naziva i fotorealizmom.

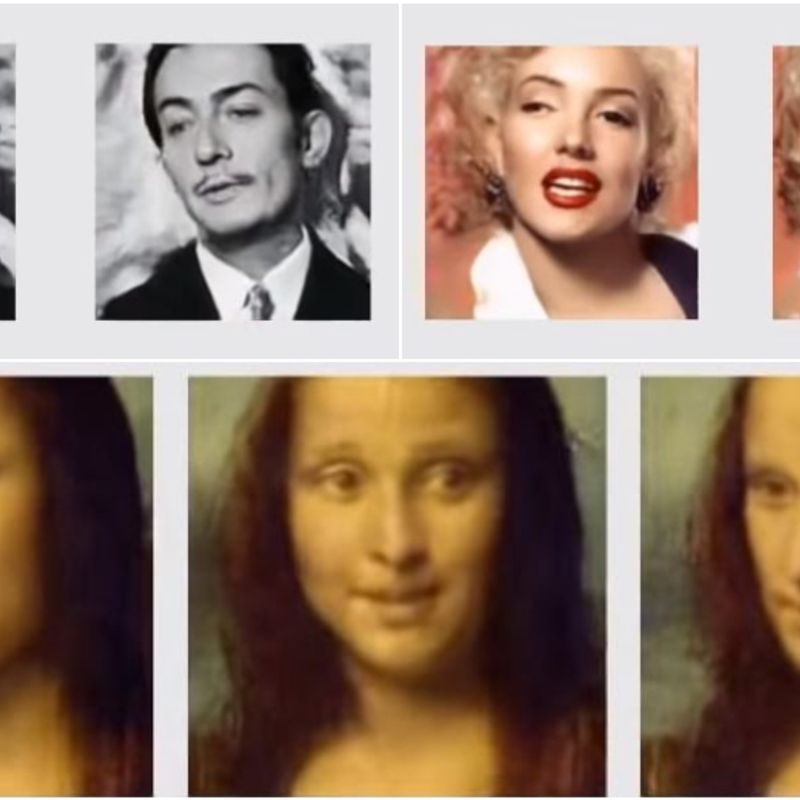

Najbolji primjer razine do koje je ova tehnologija došla je video Mona Lise u kojem ona priča, smije se i pomiče glavu i zaista izgleda kao prava osoba. Svi ovi pokreti i videa nastali su iz jedne fotografije, a dio su videa iz Samsung AI centra u kojem se laički objašnjava kako nastaje deepfake tehnologija, pokazujući da se može primijeniti i na slike, ne samo fotografije. Prije Mona Lise istu tehnologiju su isprobali s Dalijem, Einsteinom, a čak i slikom Djevojke s bisernom naušnicom, a svaki rezultat izgleda neobično dobro.

Različite ekspresije, boje i detalji umjetnih lica

Ako pogledamo promjene od 2014. godine kada se ova tehnologija tek počela razvijati do danas, došlo je do velikog napretka. U početku su generirane fotografije bile zrnaste, bez ekspresija i s jako malo boja zbog čega su sve bile vrlo slične. Danas generirana lica imaju različite ekspresije, vide im se sve strane lica, boje su izražene i jako detaljne, a osobe mogu biti u svim godinama i iz različitih kultura. Ova tehnologija i rezultati s razlogom su nazvani fotorealizmom, što ujedno povlači i mnoge negativne posljedice.

You can check out the new Dalí Lives digital experience @TheDali beginning Saturday, May 11. Have Salvador take a selfie for you. “I am Dalí!” @TB_Times pic.twitter.com/lzkXVwaPh4

— Scott Keeler (@SKeelerTimes) May 9, 2019

Da bi se ostvario rezultat, kao što možemo vidjeti po primjeru slike Mona Lise, potrebna je samo jedna fotografija. Dakako, rezultat će biti bolji ako računalo ima priliku koristiti više fotografija, ali dovoljno je strašno pomisliti da je jedna fotografija sve što je potrebno.

Komplicirana tehnologija u jednostavnim aplikacijama

Da malo objasnimo kako ova tehnologija funkcionira. Ukratko, jedna umjetna inteligencija uči od druge. Dakle, nakon što jedno računalo dobije materijale (fotografiju ili više njih), koristi tehniku učenja nazvanu generativnom kontradiktornom mrežom (GAN). Tom tehnologijom pokušava generirati fotografije koje je stvorila druga umjetna tehnologija.

Cilj u ovim koracima jest da jedna umjetna tehnologija prepozna radi li se o pravoj ili umjetno stvorenoj osobi. U tom slučaju se stvara ta ‘kontradiktorna mreža’ ili povezanost gdje jedna umjetna tehnologija uči od druge i stvara najrealnija lica koja može, što rezultira jednom od najsnažnijih tehnologija stvaranja umjetnih lica koje poznajemo.

https://www.instagram.com/p/Bx0OHRsgGaM/

Možda ovo zvuči komplicirano, ali ovakva tehnologija koristi se u vrlo jednostavnim mobilnim aplikacijama kao što su Snapchat i FakeApp, a fascinantna je i stranica This person does not exists koja na svaki klik prikazuje novo, umjetno stvoreno lice osobe.

Stvaranje lažnih vijesti na novoj razini

Dok postoji zabavna strana ove deepfake tehnologije, jer zaista jest zanimljivo da možemo vidjeti kako bi poznati izgledali da žive i danas, postoji i ona loša, ili bolje rečeno, opasna. Na deepfake tehnologiju upozorili su mnogi političari i aktivisti koji tvrde kako je ovo tek početak razvoja. Naime, negativna strana ove čudesne tehnologije je korištenje iste za nemoralne ciljeve. Tako se primjerice već mnogo puta u javnosti pojavio lažan pornografski video poznatih ličnosti, lažna videa koja nastaju s ciljem osvete, a i mnogi lažni profili na društvenim mrežama.

https://www.instagram.com/p/BxjVpD9Hxti/

Tako je i nastao naziv deepfake tehnologija jer se prvenstveno koristi za stvaranje lažnih vijesti s lažnim ljudima. Ovo ime nastalo je na Redditu 2017. nakon što su korisnici masovno počeli stavljati lica poznatih ličnosti na glumce i političare u pornografskim filmovima. Takve objave zabranili su na Redditu, Twitteru i Pornhubu. Samo neke od zvijezdi koje su bile pogođene ovakvim sadržajem su Daisy Ridley, Gal Gadot, Emma Watson, Katy Perry, Taylor Swift i Scarlett Johansson. Ovakve objave počele su utjecati i na mnoge političare s ciljem da se smanji njihov kredibilitet i da ih se ismije.

Premda je nevjerojatno pomisliti koliko će se ova tehnologija razviti ako je do današnjih rezultata došlo u samo četiri godine, moramo priznati da je i poprilično strašno.